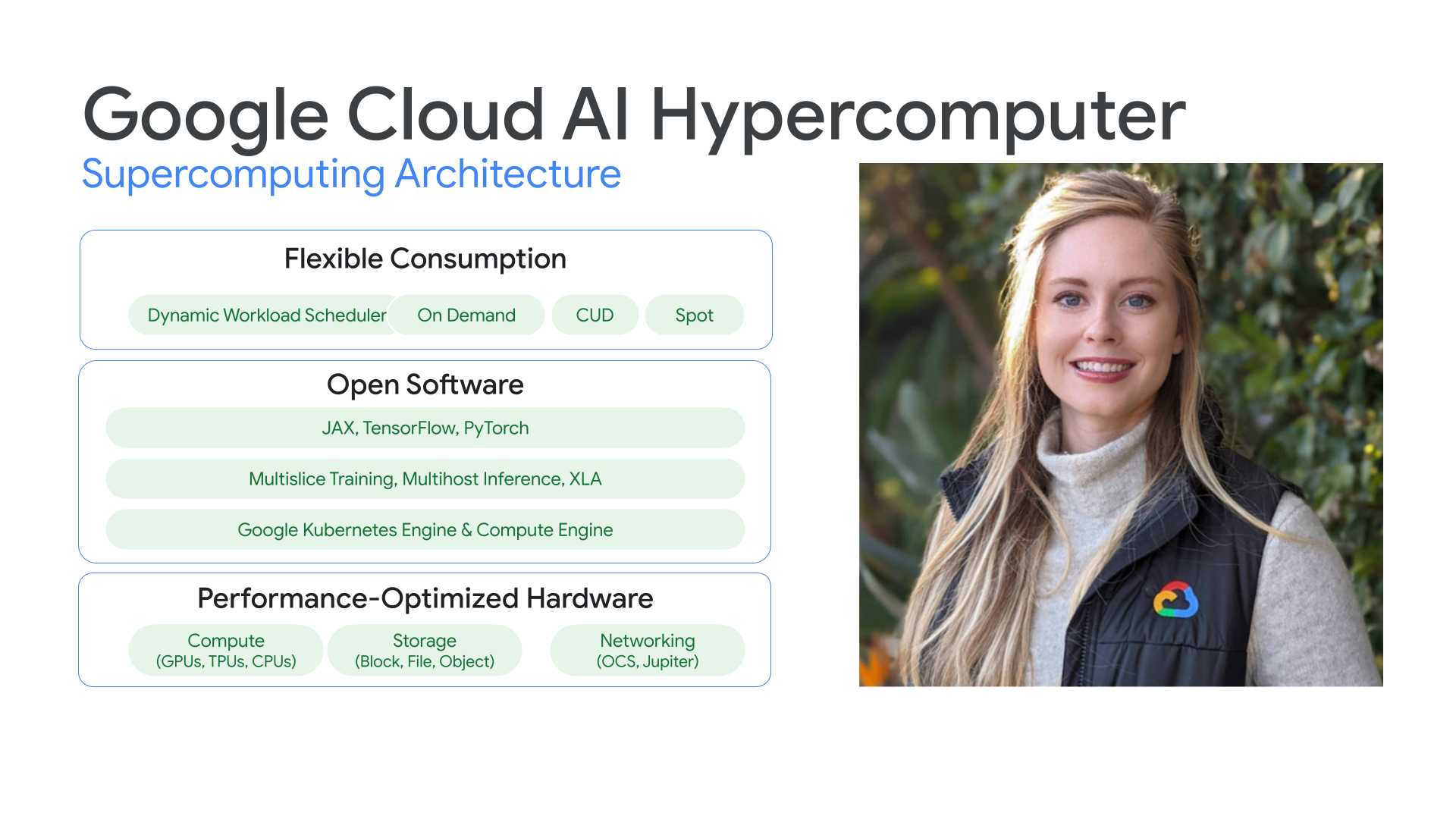

Arquitectura de supercomputación integrada

Hiperordenador con IA

Hardware, software y consumo optimizados con IA para mejorar la productividad y la eficiencia.

Información general

Hardware con rendimiento optimizado

Nuestra infraestructura con optimización del rendimiento, que incluye las TPU de Google Cloud, la GPU de Google Cloud, Google Cloud Storage y la red de Jupiter subyacente de forma coherente proporciona un tiempo más rápido para entrenar modelos de vanguardia a gran escala debido a las sólidas características de escalado de la arquitectura que ofrecen la mejor relación precio-rendimiento para servir modelos grandes.

Software libre

Nuestra arquitectura está optimizada para admitir las herramientas y bibliotecas más habituales, como Tensorflow, Pytorch y JAX. Además, permite a los clientes beneficiarse de tecnologías como las configuraciones de TPU de Cloud Multislice y Multihost y servicios gestionados como Google Kubernetes Engine. De esta forma, los clientes pueden desplegar cargas de trabajo habituales de forma inmediata, como el framework NVIDIA NeMO orquestado por SLURM.

Flexibilidad de uso

Nuestros modelos de consumo flexibles permiten a los clientes elegir costes fijos con descuentos por compromiso de uso o modelos dinámicos bajo demanda en función de las necesidades de su negocio.Gracias a Dynamic Workload Scheduler, los clientes pueden obtener la capacidad que necesitan sin tener que asignar demasiadas tareas para que paguen solo por lo que necesitan.Además, las herramientas de optimización de costes de Google Cloud ayudan a automatizar el uso de recursos para reducir las tareas manuales de los ingenieros.

Cómo funciona

Google es un líder en inteligencia artificial gracias a la invención de tecnologías como TensorFlow. ¿Sabías que puedes aprovechar la tecnología de Google en tus propios proyectos? Descubre la historia de Google en materia de innovación en infraestructura de IA y cómo puedes aprovecharla para tus cargas de trabajo.

Google es un líder en inteligencia artificial gracias a la invención de tecnologías como TensorFlow. ¿Sabías que puedes aprovechar la tecnología de Google en tus propios proyectos? Descubre la historia de Google en materia de innovación en infraestructura de IA y cómo puedes aprovecharla para tus cargas de trabajo.

Usos habituales

Ejecutar entrenamiento de IA a gran escala

Curso en IA potente, escalable y eficiente

La arquitectura de hiperordenador de IA ofrece la opción de usar la infraestructura subyacente que mejor se adapte a tus necesidades de entrenamiento.

Curso en IA potente, escalable y eficiente

Mide la eficacia de tu entrenamiento a gran escala al estilo de Google con ML Productivity Goodput.

Character AI aprovecha Google Cloud para escalar verticalmente

"Necesitamos GPUs para generar respuestas a los mensajes de los usuarios. Además, cuantos más usuarios lleguen a nuestra plataforma, necesitaremos más GPUs para ofrecer sus servicios. Por ello, en Google Cloud podemos experimentar para encontrar la plataforma adecuada para una carga de trabajo concreta. Es fantástico tener esa flexibilidad para elegir qué soluciones son más valiosas". Myle Ott, ingeniero fundador de Character.AI

Instrucciones

Curso en IA potente, escalable y eficiente

La arquitectura de hiperordenador de IA ofrece la opción de usar la infraestructura subyacente que mejor se adapte a tus necesidades de entrenamiento.

Otros recursos

Curso en IA potente, escalable y eficiente

Mide la eficacia de tu entrenamiento a gran escala al estilo de Google con ML Productivity Goodput.

Ejemplos de clientes

Character AI aprovecha Google Cloud para escalar verticalmente

"Necesitamos GPUs para generar respuestas a los mensajes de los usuarios. Además, cuantos más usuarios lleguen a nuestra plataforma, necesitaremos más GPUs para ofrecer sus servicios. Por ello, en Google Cloud podemos experimentar para encontrar la plataforma adecuada para una carga de trabajo concreta. Es fantástico tener esa flexibilidad para elegir qué soluciones son más valiosas". Myle Ott, ingeniero fundador de Character.AI

Proporciona aplicaciones basadas en IA

Aprovecha frameworks abiertos para ofrecer experiencias basadas en la IA

Google Cloud tiene el compromiso de asegurar que los frameworks abiertos funcionen correctamente en la arquitectura de hiperordenador de IA.

Aprovecha frameworks abiertos para ofrecer experiencias basadas en la IA

El ecosistema de software libre de Google Cloud te permite desarrollar aplicaciones con las herramientas y los frameworks que más te gustan, al tiempo que aprovechas las ventajas de la relación precio-rendimiento que ofrece la arquitectura hiperordenador de IA.

Priceline: Ayudamos a los viajeros a seleccionar experiencias únicas

"Trabajar con Google Cloud para incorporar la IA generativa nos permite crear un servicio de conserjería de viajes a medida en nuestro bot de chat. Queremos que nuestros clientes no solo planteen viajes, sino que les ayuden a personalizar su experiencia de viaje única". Martin Brodbeck, director de tecnología de Priceline

Instrucciones

Aprovecha frameworks abiertos para ofrecer experiencias basadas en la IA

Google Cloud tiene el compromiso de asegurar que los frameworks abiertos funcionen correctamente en la arquitectura de hiperordenador de IA.

Otros recursos

Aprovecha frameworks abiertos para ofrecer experiencias basadas en la IA

El ecosistema de software libre de Google Cloud te permite desarrollar aplicaciones con las herramientas y los frameworks que más te gustan, al tiempo que aprovechas las ventajas de la relación precio-rendimiento que ofrece la arquitectura hiperordenador de IA.

Ejemplos de clientes

Priceline: Ayudamos a los viajeros a seleccionar experiencias únicas

"Trabajar con Google Cloud para incorporar la IA generativa nos permite crear un servicio de conserjería de viajes a medida en nuestro bot de chat. Queremos que nuestros clientes no solo planteen viajes, sino que les ayuden a personalizar su experiencia de viaje única". Martin Brodbeck, director de tecnología de Priceline

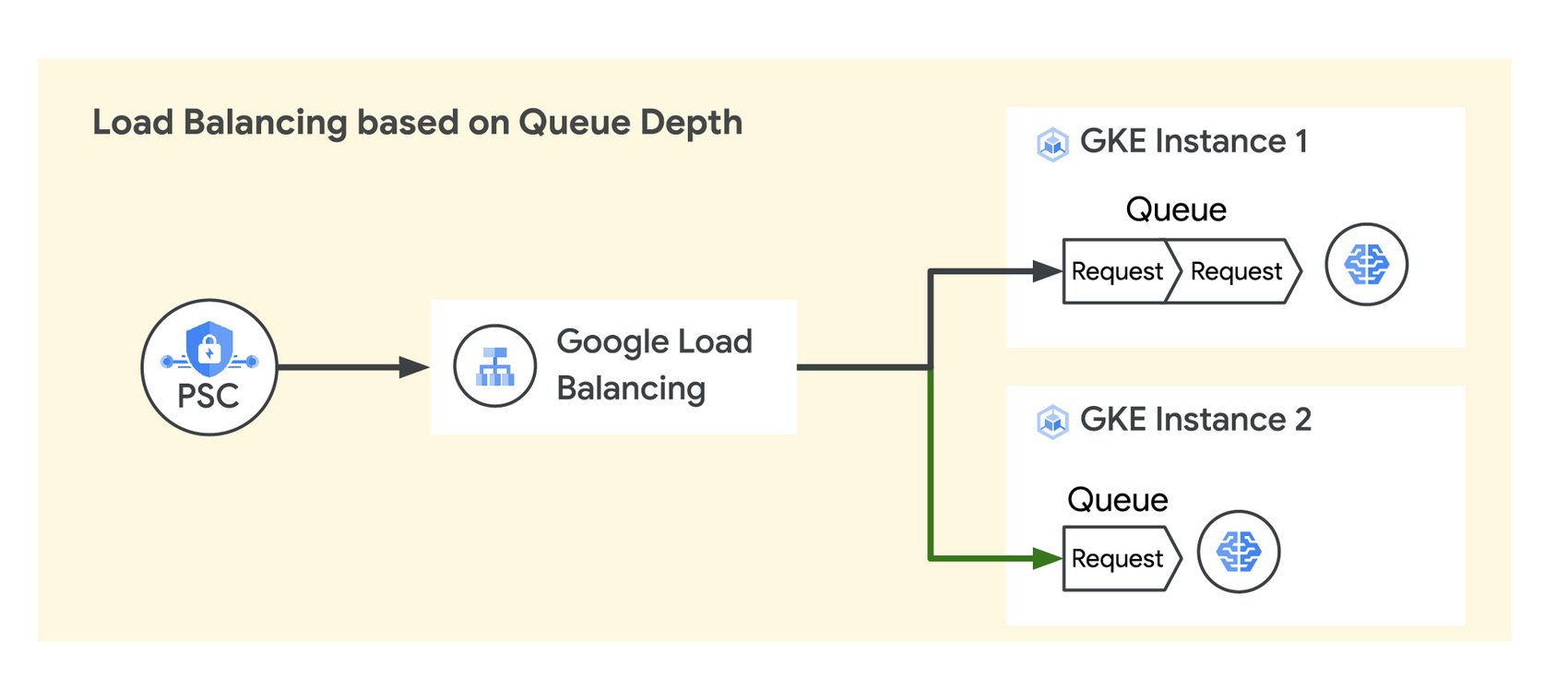

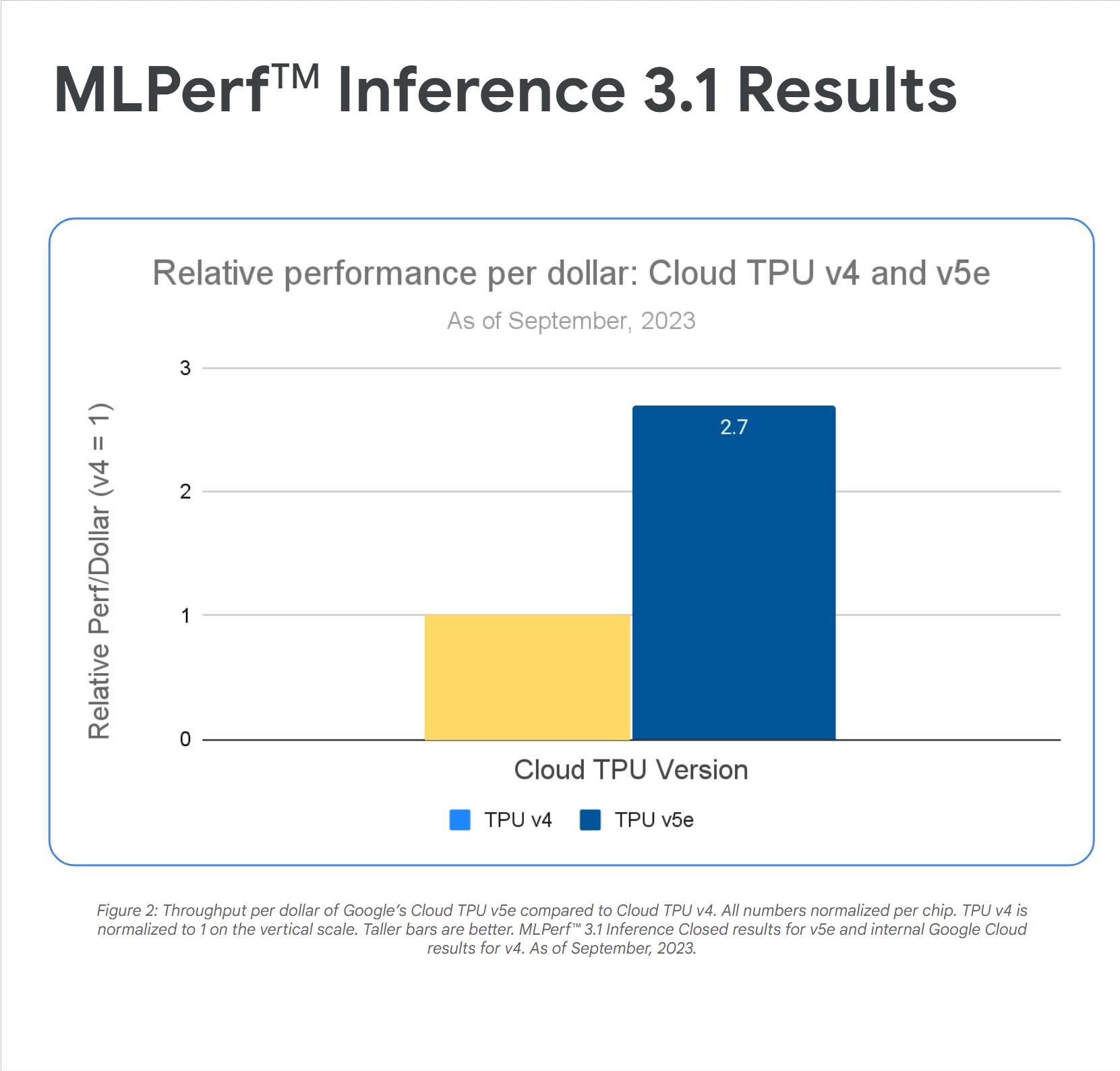

Servir modelos a gran escala de forma rentable

Maximiza la relación precio-rendimiento para servir IA a gran escala

Google Cloud ofrece un precio y un rendimiento líderes en el sector al servir modelos de IA con la opción de activar un acelerador para satisfacer las necesidades de cualquier carga de trabajo.

Maximiza la relación precio-rendimiento para servir IA a gran escala

Las instancias de VM de la versión 5e y G2 de TPU de Cloud que ofrecen GPUs NVIDIA L4 permiten obtener inferencias de alto rendimiento y rentables en una amplia variedad de cargas de trabajo de IA, incluidos los LLMs y los modelos de IA generativa más recientes. Ambos ofrecen importantes mejoras en el rendimiento de los precios con respecto a modelos anteriores, y la arquitectura hiperordenador de IA de Google Cloud permite a los clientes escalar sus despliegues a niveles líderes del sector.

Assembly AI aprovecha Google Cloud para mejorar la rentabilidad

"Nuestros resultados experimentales muestran que la versión 5e de TPU de Cloud es el acelerador más rentable para ejecutar inferencias a gran escala en nuestro modelo. Ofrece 2,7 veces más rendimiento por dólar que G2 y 4,2 veces más rendimiento por dólar que las instancias A2". Domenic Donato,

Vicepresidente de Tecnología de AssemblyAI

Instrucciones

Maximiza la relación precio-rendimiento para servir IA a gran escala

Google Cloud ofrece un precio y un rendimiento líderes en el sector al servir modelos de IA con la opción de activar un acelerador para satisfacer las necesidades de cualquier carga de trabajo.

Otros recursos

Maximiza la relación precio-rendimiento para servir IA a gran escala

Las instancias de VM de la versión 5e y G2 de TPU de Cloud que ofrecen GPUs NVIDIA L4 permiten obtener inferencias de alto rendimiento y rentables en una amplia variedad de cargas de trabajo de IA, incluidos los LLMs y los modelos de IA generativa más recientes. Ambos ofrecen importantes mejoras en el rendimiento de los precios con respecto a modelos anteriores, y la arquitectura hiperordenador de IA de Google Cloud permite a los clientes escalar sus despliegues a niveles líderes del sector.

Ejemplos de clientes

Assembly AI aprovecha Google Cloud para mejorar la rentabilidad

"Nuestros resultados experimentales muestran que la versión 5e de TPU de Cloud es el acelerador más rentable para ejecutar inferencias a gran escala en nuestro modelo. Ofrece 2,7 veces más rendimiento por dólar que G2 y 4,2 veces más rendimiento por dólar que las instancias A2". Domenic Donato,

Vicepresidente de Tecnología de AssemblyAI